Innhold

15. oktober 2019Hvis du søker etter en smarttelefon med et godt kamera, er det ingen tvil om at du har sett Googles Pixel-serie på en liste over anbefalinger. År over år har Google funnet ut hvordan man lager et kamera som gir gode resultater hver eneste gang. Fra pixel-peeping tech-blogger til den daglige forbrukeren, det er vanskelig å finne en enkelt person som ikke elsker Pixels kameraer.

Bortsett fra prøver Google ikke å lage kameraer. Den prøver å lage magi.

-

- Marc Levoy

-

- Isaac Reynolds

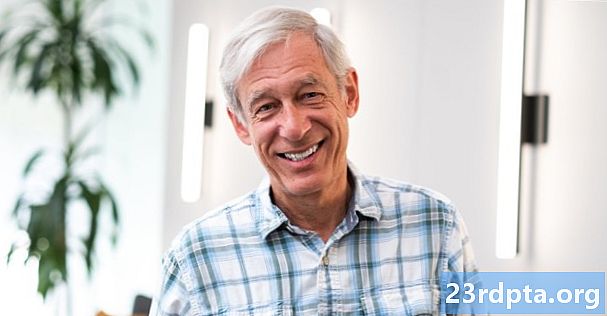

Jeg hadde nylig muligheten til å sette meg ned med Marc Levoy og Isaac Reynolds - kjernene i bakgrunnen for Pixel-seriens frustrerende godt kamerasystem. Vi hadde lange samtaler om de nye funksjonene i Pixel 4s kamera, fra det forbedrede Night Sight til WYSIWYG (What You See Is What You Get) i sanntid HDR + søker. Det var mye teknisk snakk om hvordan Google muliggjør disse funksjonene, men en ting ble gjort krystallklart mot slutten. Googles Pixel-kamera handler ikke i det hele tatt om å prøve å være et kamera.

"Vår kjernefilosofi bygger et kamera som gjør magi, som er den kombinasjonen av enkelhet og bildekvalitet," forklarte Reynolds. "Så nattesikt er fortsatt der, standard HDR + er fremdeles der. All prosessering som foregår under panseret for å få et flott bilde fra standardmodus er fremdeles der. Og vi har også gjort mye mer forenkling. "

Standard modus. Forenkling. Magic. Dette er setninger som Google bruker som en del av kjernefilosofien for Pixels kamera. Levoy og Reynolds sinn trenger ikke å fange øyeblikket å handle om modusvelger og innstillingsmenyer.Google prøver ikke å bygge et kamera inn i telefonen, den prøver å bygge noe som gjør konsekvent flotte bilder ut av porten, på tradisjonelle måter eller på annen måte.

Det du ser er hva du får

![]()

En av Pixel 4s nye funksjoner er WYSIWYG-søkeren, noe som betyr at du vil se resultatene av HDR + før du selv tar skuddet. Dette kan virke som en liten funksjon, men det muliggjør noen ting som bare ikke er mulig i ikke-beregningsdrevne kameraer.

Målet med den WYSIWYG-søkeren er å redusere brukerinteraksjonen så mye som mulig. Ved å vise det resulterende bildet rett når du åpner kameraet, vet du om du får en jevn eksponering umiddelbart, og kan bare fokusere på å spikre bildet ditt.

"Hvis vi ser at brukeren tappet, vet vi at kameraet ikke ga dem det de ønsket fra begynnelsen." Fortsetter Reynolds, "Så et trykk, for meg, er potensielt en feiltilfelle som vi ønsker å forbedre .”

Tradisjonelle kamerasystemer er ganske dårlige til å få bildet du vil ha rett ut av kameraet. Du kan enten eksponere for høydepunktene og heve skyggene senere, eller eksponere for skyggene, men blåse ut høydepunktene. Takket være teknologi kan vi gjøre begge deler, og det er her beregningsfotografering virkelig begynner å få den magien til å skje.

"Å ha en WYSIWYG-søker nå betyr at vi kan tenke nytt om hvordan du kontrollerer eksponeringen på kameraet hvis du vil." Sier Levoy, "Så hvis du trykker på, mens før du ville fått en glidebryter for eksponeringskompensasjon, får du nå to glidere. Vi kaller denne funksjonen Dual Exposure Control. Og det kan være høydepunkter og skygger. Det kan være lysstyrke og dynamisk rekkevidde. Det er mange måter du kan gjøre de to variablene på. Vi har lagt opp til å gjøre lysstyrke og skygger. Og det gir deg en slags kontroll som ingen noen gang har hatt på et kamera før. ”

Du redigerer bildet før du tar bildet.

Levoy har rett. Dobbel eksponeringskontroll er noe som bare kan produseres gjennom beregningsavbildning. Som en grunnlinje vil bildet være jevnt, med bevarte høydepunkter og synlige skygger. Men hvis du vil, har du kraften til å justere høydepunkter og skygger individuelt, før du selv tar bildet. Det er noe du tidligere bare kunne gjøre i programvare for fotoredigering, etter at du har tatt bildet.

Levoys team prøver å se forbi begrensningene til det tradisjonelle kameraet ved å fokusere sin innsats på de begrensningene tradisjonelle kameraer har. Mens de fleste produsenter introduserer Pro-modus for å gi deg kontroll over blenderåpning, lukkerhastighet og ISO, prøver Google automatisk å lage et bedre bilde enn du kunne, selv om du hadde disse knappene helt riktig.

Drep det med læring

![]()

Så hvilke andre måter kan beregningsmessige imaging utover tradisjonelle kamerateknikker? I år takler Levoys team lite lys.

Pixel 4 introduserer læringsbasert hvitbalanse i kamerasystemet. Denne funksjonen forbedrer kontinuerlig farge på bildene dine, selv i ekstremt dårlig lys. Google retter seg spesielt mot lite lys og gult lys og brukte Sodium Vapor-lys som et eksempel på noe den prøver å fikse, men tar sikte på å få perfekt hvitbalanse hver gang.

Natriumdamplamper er en type gasslampe som gir en nesten monokrom effekt på personer på grunn av den ekstremt smale bølgelengden på 589nm til 589.3nm. De blir brukt fordi de er en svært effektiv lyskilde, så du vil ofte se den i gatelamper eller andre lys som trenger å vare lenge. Dette er en av de vanskeligste situasjonene å få nøyaktig hvitbalanse fra, så Googles programvarefix er virkelig imponerende.

"Ville være gult når det gjelder natriumdamplys, og vi vil prøve å nøytralisere den dårlige belysningen," sier Levoy. “Skjer mye i svakt lys. Hvis du går inn i et diskotek og det er røde neonlamper, vil det bevare det, men vil prøve å nøytralisere noe av belysningen i ugunstige områder. "

Læringsbasert hvitbalanse var allerede til stede i Googles Night Sight-modus, og det er grunnen til at det endelige bildet hadde mye bedre farge enn noe som automatisk modus på Huawei P30 Pro. Systemet lærer basert på bilder som er tatt på enheten, det virker som balansert, og bruker innlærte data for å produsere mer fargenøyaktige bilder under dårlig opplyste omstendigheter. Dette er noe tradisjonelle kamerasystemer bare ikke kan gjøre. Når et kamera er sendt, er hvitbalanse automatisk hvitbalanse. På Pixel fungerer det alltid for å bli bedre over tid.

Læringsbasert hvitbalanse gjør flotte bilder med lite lys enda enklere, men Levoy ønsker å bruke datamaskiner for å forenkle en en gang vanskelig form for avbildning - astrofotografering.

Se til stjernene

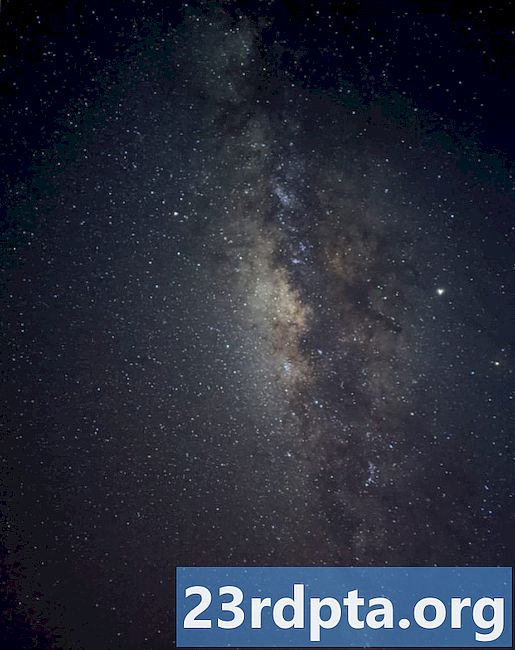

Kilde: Google

Levoy kaller denne nye muligheten “HDR + on steroids”. Der standard HDR + tar et spreng på 10-15 korte eksponeringer og justerer og gjennomsnitt dem for å få skarpe bilder med lite støy, tar denne nye modusen opptil 15 sett med 16 sekunders eksponeringer, for å skape en 4-minutters eksponering. Systemet justerer deretter bildene (siden stjerner beveger seg over tid) og justerer de riktige innstillingene mens de reduserer støy med pikselverdi for å lage noen forbløffende bilder.

Dette var en slags hellig gral for meg.

Marc LevoyLevoy viste meg noen eksempler på bilder teamet hans tok av melkeveien, og kjeven min falt bokstavelig talt. Selv om det er mulig å gjøre lange eksponeringer på tradisjonelle kamerasystemer, trenger du vanligvis ekstra utstyr for å snu kameraet over tid hvis du vil ha ekstra skarpe bilder. Med Night Sight kan du ganske enkelt støtte telefonen mot en stein, treffe skodda, og enheten gjør resten.

Kanskje den smarteste delen av denne nye Astro Night Sight-modus er at den ikke er en egen modus i det hele tatt. Det hele skjer med Night Sight-knappen. HDR + bruker allerede gyroskopet for å oppdage bevegelse og justere bilderutbrudd, og Night Sight vil nå oppdage hvor lang tid det kan ta et bilde, avhengig av hvor stød enheten er når du trykker på utløserknappen, opptil fire minutter. Den vil også oppdage himmel ved hjelp av en metode som kalles Semantic Segmentation, som lar systemet behandle visse områder av bildet på en annen måte for å få det beste resultatet.

-

- Kilde: Google

-

- Kilde: Google

"Vi vil at ting skal være enkelt for alle å bruke," sier Reynolds, "Så når vi finner noe i produktet som ikke trenger å være der, kan vi ta det ansvaret fra deg og løse det for deg."

Denne uttalelsen koker virkelig ned hva Google prøver å gjøre med Pixels kamera. I stedet for å se hvordan de kan få det til å fungere som et kamera, prøver Google å løse problemer du ikke en gang visste at eksisterte, og presentere det i en enklest mulig form.

Selvfølgelig er det fordeler for begge sider. Noen mennesker kan det vil et telefonkamera som fungerer som et kamera, med manuelle kontroller og ringer. De vil kanskje ha større sensorer og Pro-modus. Men mens andre ODM-er fokuserer nesten utelukkende på maskinvare, ser Google i en helt annen retning.

Det er ute etter å lage magi.

Vil du lære mer om beregningsfotografering? Sjekk ut videoen over for å se hvordan dette feltet vil endre måten vi lager bilder.

Pixel 4